화이트 모드로 보시길 권장합니다

[AI Friends School] 시리즈는 MicroShcool에서 진행하는 온라인 인공지능 학습 학교이다.

AI Friends School 강의 내용을 말하기 전, AI Friends School에선 어떠한 것을 배우는지 알아보자

AI Friends School이란?

AI Friends School은 인공지능 기술을 적용해 세상의 문제를 해결할 수 있는 시티즌 디벨로퍼로 성장하는 것을 목표로 한다.

-AI Friends School 온라인 과정 ( 36차시, 3개월 )-1. 인공지능 들어가기(1차시 ~ 10차시) 2. 인공지능·영상처리 이론(11차시 ~ 15차시) 3. 인공지능·영상처리 실습(16차시 ~ 23차시) 4. 인공지능·음성 / 자연어 처리 이론(24차시 ~ 28차시) 5. 인공지능·음성 / 자연어 처리 실습(29차시 ~ 36차시)

인공 신경망

인공 신경망( Artifical Neural Network; ANN )

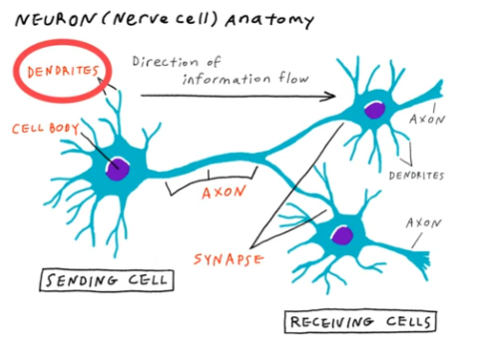

컴퓨터를 학습시키기 위해 뇌의 동작 원리에 기초하여 만들어진 구조이다.

인간의 뇌가 가지는 뉴련의 연결 구조를 컴퓨터로 구현한 네트워크 구조를 의미한다.

단층 퍼셉트론

퍼셉트론( Perceptron )

뇌 를 구성하는 기본 세포인 뉴런을 컴퓨터로 구현한 것이 퍼셉트론이다.

입력, 가중치, 전이함수, 활성화 함수로 구성되어 있다.

퍼셉트론의 구조와 뉴런의 구조 비교 :

입력 :

뉴런이 자극을 받아들이는 부분, 수상 돌기를 구현한 것이다.

외부에서 데이터를 받아들이는 역할을 한다.

컴퓨터에선 변수 x와 데이터의 개수를 뜻하는 n을 이용하여 x₁, x₂, x₃, x₄...Xn으로 표현한다.

가중치 :

각 입력값들의 중요로를 반영하기 위한 수치이다.

가중치는 Weight; W로 표현한다.

퍼셉트론에서 가중치를 나타낼 경우, 각각의 입력값 x₁, x₂, x₃, x₄...Xn에 가중치를 곱하여(w₁*x₁, w₂* x₂, w₃*x₃...) 표현한다.

각 데이터의 중요도를 정확하게 설정하는 정도에 따라 모델의 예측 정확성이 바뀐다.

전이함수 :

입력 데이터에 각각의 가중치의 값을 곱한것을 합한 후, 다음 함수로 전달하는 역할을 수행한다.

활성화 함수 :

뉴런이 이전 뉴런의 값에게 받은 자극 값이 일정 용량을 넘게 될 경우 다음 뉴런으로 값을 전달한다.활성화 함수는 전이함수에게 받은 데이터의 크기가 일정량을 넘게 될 경우 그 값을 출력할 수 있게 한다.출력의 기준이 되는 값을 임계값 이라 한다.

( ex. 물을 예시로 들 때, 물이 일정 온도에 따라 상태가 바뀐다. 이때 상태가 변화되는 ' 온도 '가 임계값이다. )

단층 퍼셉트론의 경우 전이함수를 통해 받은 데이터가 임계값 0을 넘게 될 경우 1(True), 아닐 경우 0(False)로 표현한다.

다층 퍼셉트론

다층 퍼셉트론( Multi Layer Perceptron; MLP )의 탄생

현실의 문제는 전부 수학적 법칙을 따가는 것이 아니기에 퍼셉트론만으로 해결하기 어렵다.

특히, 두개의 명제중 하나만 참일 경우를 판단하는 베타적 논리합(Exclusive Or; XOR)의 경우일 때 문제가 자주 발생했다.

XOR과 같은 상황을 해결하기 위해 만들어 진 것이 다층 퍼셉트론( Multi Layer Perceptron; MLP )이다.

( XOR이 세상의 모든 상황에 맞지 않다는 지적을 받게 되며 인공지능의 1차 겨울을 맞게 되었다. )

( ' 인공지능의 겨울 '에 관한 내용은 아래 글에서 확인할 수 있다. )

[AI Friends School] - [AI Friends School 1차시] 인공지능의 탄생 & 개념

[AI Friends School 1차시] 인공지능의 탄생 & 개념

화이트 모드로 보시길 권장합니다 [AI Friends School] 시리즈는 MicroShcool에서 진행하는 온라인 인공지능 학습 학교이다. AI Friends School 강의 내용을 말하기 전, AI Friends School에선 어떠한 것을 배우는

smcjungbumc.tistory.com

다층 퍼셉트론( Multi Layer Perceptron; MLP )

하나의 문제에 사용되는 퍼셉트론의 개수를 늘려 사용하는 것을 의미한다.

단층 퍼셉트론이 여러개 모여 다층 퍼셉트론을 이룬다.

단층 퍼셉트론의 수가 3개 이상일 경우 심층 신경망, 인공 신경망이라 한다.

퍼셉트론의 수가 늘어남에 따라 같은 역할을 하는 층을 입력층, 은닉층, 출력층으로 구분할 수 있다

인공 신경망의 구조

입력층

입력을 받는 노드를 묶어 부른다.

은닉층

입력층과 출력층 사이에 존재하는 모든 층(노드, 간선 등)을 묶어 부른다.

입력된 데이터는 입력층에서 수많은 가중치에 영향을 받아 그 값이 변화한다.

은닉층 값의 합을 시그마(Σ)를 이용해 나타낸 값을 가중합이라 한다. 전이 함수에서 이를 수행한다.

( 가중합 수식 ex. w₁*x₁ +w₂* x₂ + w₃*x₃ + w₄*x₄ = Σwi*xi )

은닉층에서 계산된 값은 전이함수를 통해 출력층으로 이동된다.

출력층

값을 출력하는 역할을 한다.

출력층 내에는 값의 출력 여부를 결정하는 활성화 함수가 있다. 이는 은닉층의 값을 사용자가 이해 가능토록 변환해 준다.

활성화 함수를 통해 데이터를 이해하기 쉽도록 처리하는 것이 필요하다.

( 활성화 함수에 대한 내용은 아래 글에서 확인 가능하다. )

[AI Friends School] - [AI Friends School 6차시] 인공지능 수학

[AI Friends School 6차시] 인공지능 수학

화이트 모드로 보시길 권장합니다 [AI Friends School] 시리즈는 MicroShcool에서 진행하는 온라인 인공지능 학습 학교이다. AI Friends School 강의 내용을 말하기 전, AI Friends School에선 어떠한 것을 배우는

smcjungbumc.tistory.com

인공 신경망의 학습

인공지능 모델의 학습 방법

인공 신경망의 결과 값은 가중치, 활성화 함수에 의해 변화 하기에, 가중치, 활성화 함수가 가장 중요한 요소이다.

학습 방법 :

가중치, 활성화 함수의 값을 랜덤으로 설정.

신경망을 계산, 인공 신경망의 출력값을 기준으로 답과 비교하여 가중치를 증가 혹은 감소시켜 적절한 출력값이 나오도록 만든다.

단층 신경망 혹은 단순한 신경망을 학습시키는 경우 가중치, 편향 값을 하나씩 변화시키며 학습을 진행해도 된다.

오차 역전파법( Back Propagtion ) :

여러개의 퍼셉트론으로 이루어진 심층 신경망의 가중치를 효율적으로 조정하는 방법이다.

출력값을 계산하는 과정인 순전파( Feedforward ) 연산 이후 출력값(예측값)과 정답값의 오차를 다시 반대 방향으로 보내며 많은 노드를 가진 심층 신경망도 최적의 가중치와 활성화 함수의 값을 학습할 수 있게 하는 방법이다.

( 오차 역전파법에 대한 내용은 추후 오차 역전파법의 대한 개별의 글에서 다루겠다. )

가중치(Weight; W)와 편향값(Bias; b)을 학습할 경우 cost값이 최소인 값을 찾는 경사하강법을 사용하여 값을 구할 수 있다.

( 경사 하강법에 관련된 내용은 아래 글에서 확인할 수 있다. )

[AI Friends School] - [AI Friends School 6차시] 인공지능 수학

[AI Friends School 6차시] 인공지능 수학

화이트 모드로 보시길 권장합니다 [AI Friends School] 시리즈는 MicroShcool에서 진행하는 온라인 인공지능 학습 학교이다. AI Friends School 강의 내용을 말하기 전, AI Friends School에선 어떠한 것을 배우는

smcjungbumc.tistory.com

다음 차시에는 이미지 데이터에 대해 배운다.

'AI Friends School' 카테고리의 다른 글

| [AI Friends School 8차시] 이미지 데이터의 이해 (1) | 2023.01.19 |

|---|---|

| [AI Friends School 6차시] 인공지능 수학 (2) | 2023.01.10 |

| [AI Friends School 5차시] 인공지능의 성능 평가 및 개선 방법 (0) | 2022.12.31 |